在人工智能技术迅猛发展的今天,本地化部署大型语言模型已成为保障数据隐私与提升响应效率的重要方式。作为国内领先的AI开发平台,DeepSeek凭借其开源的模型架构和高效的推理性能,吸引了大量开发者和企业用户的关注。本文将从功能特点、下载指南、使用教程及安全性等维度,系统解析如何高效部署与使用这一工具。

一、DeepSeek的核心功能与优势

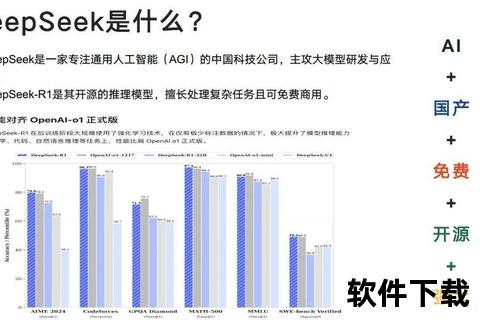

DeepSeek的独特之处在于其灵活性与高性能的平衡。其模型库覆盖从1.5B到671B参数的多种版本,用户可根据硬件配置选择适配的模型:

DeepSeek支持离线运行与多语言交互,通过Ollama框架实现一键部署,显著降低了技术门槛。其开源特性还允许开发者自定义训练模型,形成私有化AI解决方案。

二、本地部署的完整流程

步骤1:系统环境准备

步骤2:安装Ollama框架

1. 访问[Ollama官网]下载安装包。

2. 修改默认安装路径(避免占用C盘空间):

bash

Windows系统示例

OllamaSetup.exe /DIR=D:Ollama

3. 设置模型存储路径:

bash

添加系统环境变量

OLLAMA_MODELS=D:OllamaImages

步骤3:下载与运行模型

bash

下载8B参数模型

ollama run deepseek-r1:8b

若下载中断,可通过`Ctrl+C`终止进程后重试。安装成功后输入`ollama list`查看已载入模型。

三、安全防护与风险规避

本地部署需警惕以下安全隐患:

1. 端口暴露风险:Ollama默认使用11434端口,若需公网访问,需通过防火墙限制IP或使用反向代理工具(如Nginx)添加Basic Auth认证。

2. 版本漏洞:及时升级至Ollama 0.1.34+版本,修复CVE-2024-37032等远程执行漏洞:

bash

ollama update

3. 模型来源验证:仅从[DeepSeek官网]或可信渠道获取模型,避免恶意代码注入。

四、用户场景与实操案例

场景1:自动化简历分析

1. 上传ZIP格式简历压缩包至DeepSeek工作目录。

2. 执行命令:

python

from deepseek import DataProcessor

processor = DataProcessor(model="deepseek-r1:14b")

processor.analyze_resumes("resumes.zip", output_format="excel")

系统将自动解压文件、提取关键信息并生成可视化排名表。

场景2:金融市场预测

调用API接入实时数据流:

python

import deepseek_finance as df

df.set_api_key("YOUR_KEY")

report = df.generate_market_report("NASDAQ", days=30)

report.export_to_html("analysis.html")

该功能可生成包含趋势图表与风险评估的自动化报告。

五、用户反馈与未来展望

真实用户评价

技术发展趋势

DeepSeek计划在2025年推出以下更新:

1. 混合专家模型(MoE):提升推理效率,降低70%硬件消耗。

2. 生态开放:扩展API接口,支持与Manus等执行层工具协同,形成“决策-执行”闭环。

3. 量子计算适配:探索与量子硬件的兼容性,突破传统算力瓶颈。

DeepSeek的本地化部署为个人与企业提供了安全可控的AI解决方案。用户需根据实际需求选择模型规模,并严格遵守安全规范以避免风险。随着其开源生态的完善与技术迭代,DeepSeek有望成为AI平权化进程中的重要推动者。对于初次接触的用户,建议从7B模型起步,逐步探索更复杂的应用场景。